Depuis quelques semaines l’IA générative ChatGPT génère de nombreuses prises de parole oscillant entre fascination et inquiétude. Mon précédent article « L’enseignement supérieur et les IA génératives : analyse critique de la situation autour de ChatGPT » a d’ailleurs été lu des milliers de fois. La phrase qui a beaucoup surpris a été : « si ChatGPT réussi l’examen, alors il faut changer l’examen »… et pourtant, c’est une invitation très nette à redéfinir les approches des devoirs et des examens dans le cadre d’une pédagogie moderne.

Dans le présent article, je vais donc me focaliser plus spécifiquement sur le sujet de ChatGPT et des devoirs ou des examens pour esquisser quelques pistes sur les actions possibles : de l’interdiction à l’utilisation de ChatGPT.

Encadrer l’utilisation de ChatGPT

Le premier réflexe, comme celui des établissement de New-York, peut être d’interdire l’usage de l’outil.

D’un point de vue technique, il existe la possibilité d’interdire l’accès réseau au domaine OpenAI.com (et à tous les autres domaines proposant des IA génératives basées sur GPT-3). Cette démarche est peu efficiente car très facilement contournable et surtout quasi ingérable tant le phénomène va se répandre et donc les points d’entrée vont être multiples. Ainsi, le jours où cet outil est intégré dans Office 365 par Microsoft, il sera complètement vain d’envisager cette approche. Il est aussi possible d’utiliser une approche de type proctoring où on va « fixer » l’étudiant sur des fenêtres autorisées sur son ordinateur… là aussi l’outil devenant accessible via téléphone portable, cela présente une efficacité toute relative.

La deuxième possibilité est de rebasculer les devoirs ou examens en salle et de les faire écrire à la main pour surveiller l’usage réalisé des appareils connectés (et ainsi éviter toute triche à l’examen). Cette technique, bien que toute simple, sera très efficace pour limiter l’usage de ChatGPT.

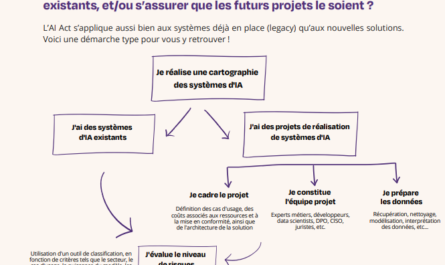

Il faut définir une position claire sur l’usage des IA génératives : ce qui est autorisé, ce qui ne l’est pas et dans quel contexte.

Toutefois, il me semble plus important encore de définir une position claire sur l’usage des IA génératives comme ChatGPT dans l’établissement ou dans les examens : ce qui est autorisé, ce qui ne l’est pas et dans quel contexte. Il convient donc de donner une véritable définition de ce qui est autorisé ou non avec cet outil afin d’éviter tout plagIAt (plagiat assisté par IA, les anglo-saxons parlent de AIgiarism) et sous quelles conditions. Cela nécessite ainsi d’indiquer clairement aux étudiants la politique sur le sujet et de détailler les sanctions encourues (généralement les mêmes que pour tricherie avérée). Il est tout aussi important, si l’usage est autorisé, de proposer un cadre clair à cet usage en demandant d’indiquer explicitement les passages ayant mobilisé l’IA, et évidemment de ne pas mettre simplement « ChatGPT » dans la bibliographie car c’est à peu près aussi précis que d’indiquer « Internet » comme source bibliographique ! Il pourrait être pertinent de faire indiquer à l’étudiant le ou les prompts utilisés par rapport au passage de texte concerné et de faire ajouter en annexe le résultat fourni par l’outil, c’est le minimum pour citer correctement ChatGPT.

Faire indiquer le prompt utilisé et le résultat fourni par ChatGPT relève du minimum à demander aux étudiants.

Quand on interroge ChatGPT sur une politique claire (et restrictive) d’usage aux examens universitaires, cela donne ceci :

Et quand on demande une politique autorisée et pertinente de l’utilisation de ChatGPT les propositions sont :

Je suis sûr que chaque établissement saura écrire sa propre politique afin d’assurer et de garantir l’intégrité académique, mais surtout, la bonne formation des étudiants au monde d’aujourd’hui.

Par ailleurs, dans les recommandations, il est clair qu’il faut travailler sur l’examen lui même. C’est la suite de l’article justement !

Changer la forme de restitution du devoir ou de l’examen

Bien qu’il fasse peur, il y a un certain nombre de choses que ChatGPT ne sait pas manipuler. Travailler la forme de la restitution est donc important car l’outil sera bien en peine pour répondre. Ainsi, nous avons listé quelques possibilités ici :

- faire écrire à la main : cela paraît basique, mais cela obligera les étudiants à réfléchir un minimum à ce qu’ils sont en train d’écrire (et c’est autrement plus fastidieux qu’un copier-coller).

- utiliser des QCM, des réponses en vrai-faux, ou de la logique : en effet, il est très facile de tromper l’outil qui ne comprend pas ce qu’il écrit. Toute forme de raisonnement va donc le dépasser très rapidement. Un exemple trivial ici :

- utiliser du graphisme, des cartes mentales, toute autre forme d’expression que le simple texte : personnellement j’utilise cette technique pour apprendre à mes étudiants à restituer les concepts de manière plus impactante en quittant la logique PowerPoint ou les longs pavés de texte qui ne disent rien de bien intéressants.

- utiliser la vidéo : la vidéo est aujourd’hui omniprésente dans la vie de nos étudiants, et ils ont souvent de vrais talents de storytelling. C’est un support d’expression aujourd’hui devenu très simple, impactant et pertinent. En tout cas très utile aussi pour eux de savoir s’exprimer intelligemment en vidéo !

Changer le devoir ou l’examen lui-même pour faire échouer ChatGPT (et faire réfléchir nos étudiants)

Comme indiqué ci-dessus, dans de nombreux cas, ChatGPT va être très en difficulté pour répondre de manière pertinente. En effet, ChatGPT fonctionne en « prédiction du mot suivant » pour construire le texte, à nouveau, sans compréhension de ce qui est écrit. Ainsi, quand une information manque, il va inventer la plus plausible en utilisant une « ungraceful degradation » : ce phénomène n’est pas gênant dans une démarche créative, mais le devient beaucoup plus quand il s’agit de répondre à une question ou de réaliser une synthèse. Merci à Yves Caseau pour l’exemple assez tordant autour des médecins et de leur durée de travail déraisonnable de 24 minutes (car l’outil « confond » minutes et heures dans cet exemple) :

On voit donc bien ici que dans les usages non créatifs il est utile d’être compétent pour utiliser ChatGPT comme aide cognitive ou alors rester sur des questions très larges de sorte à ce que les data d’apprentissage soit forcément pertinentes. Ainsi toute questions précises (avec peu de data dessus) ou toutes les questions demandant de la logique ou une analyse originale vont mettre l’outil hors service. Dès lors de nombreuses pistes s’ouvrent à nous :

- Faire appliquer les concepts à un cas spécifique : par construction si ce cas est en plus spécifique et « peu connu », c’est à dire que le corpus sur ce cas est faible dans GPT-3, alors l’outil ne sera pas d’une grande aide. Cela invite à être moins sur la mémorisation du concept que son usage.

- Plus globalement tout sujet moins « mainstream » ou plus récent (les données s’arrêtent en novembre 2021 pour le moment dans ChatGPT), sera mal géré par ChatGPT car absent de son corpus (partiellement ou totalement).

- Quitter le « une bonne réponse attendue » pour aller vers une réflexion sur son propre raisonnement : par exemple en faisant analyser les évolutions de versions entre les documents rendus (si c’est un mémoire), demander à analyser un texte / un travail sous plusieurs angles avec plusieurs visions (et les faire comparer), à travailler sur les nuances des points de vue. Cela revient à faire davantage réfléchir sur la stratégie de réponse plus que la réponse elle-même.

- Focaliser sur la compétence (plus que le savoir), focaliser sur le sens plus que la simple exécution, sur l’analyse critique plus que la mémorisation : vaut-il mieux savoir planter un clou ? savoir ce qu’est un clou ? donner la définition du clou ? se poser la question de pourquoi le clou ? proposer des alternatives pertinentes au clou (la vis) ? etc. ou tout ça en même temps ?

- Faire élaborer des stratégies de veille, de curation, et de réflexion : là encore, cela reviendrait à amener nos étudiants à développer de vraies pratiques de collecte d’information mais surtout d’analyse de ces informations. C’est une compétence qui va devenir cruciale à l’heure d’une génération de contenus automatisés et en continu.

Après le devoir ou l’examen : identifier et contrer ChatGPT ?

Il existe aujourd’hui de nombreux outils « anti-ChatGPT » comme GPTZero, AI Content Detector, Giant Language Model Test Room, Opportunity ou encore Open AI GPT-2 Output detector. Toutefois, cela reste encore très complexe et les outils de détection sont facilement dans le faux… Le mieux placé risque toutefois d’être celui de OpenAI qui ainsi va pouvoir vendre l’outil et son antidote… en effet, seuls eux ont une connaissance profonde des structures de texte / de vocabulaire les plus courantes de ChatGPT et seuls eux pourraient apposer une sorte de « watermarking », véritable signature d’authentification du contenu généré par leur IA.

Toutefois, un cerveau humain peut assez facilement identifier un contenu généré par ChatGPT : les structures de phrase, l’assertivité, la structure de réponse est plutôt très régulière et récurrente (surtout si le prompt initial est basique). Il n’y ainsi aucun ton, aucune emphase, c’est une écriture « mécanique ». Par ailleurs, un autre élément doit susciter le questionnement : l’absence de fautes d’orthographe, une très grande constance grammaticale, une régularité trop grande dans le style d’écriture et une similarité d’une copie à une autre sont des signaux d’alerte.

L’autre possibilité après le devoir est aussi de relever le niveau d’exigence de ce qu’est une copie « moyenne », de donner un bonus à toute expression d’un point de vue original, contrasté, critique, etc. ou encore de favoriser « la prise de risque », l »innovation » ou la vraie « créativité » dans la réponse et la forme de la réponse. Concernant l’évaluation, il est à nouveau nécessaire d’avoir été très clair sur le cadre autorisé ou non d’utilisation de l’outil (cf. paragraphe 1 de cet article).

Utiliser l’outil dans les devoirs ou les examens ?

Comme déjà évoqué dans mon précédent article ChatGPT peut aussi largement être l’allié des pédagogues. Il sera par exemple aisé de créer des quiz, des QCM, des dictées en utilisant l’outil d’OpenAI.

Au delà de ça, j’aimerai ici proposer d’inverser les rôles et de placer l’étudiant en « correcteur » des réponses de ChatGPT afin de le faire réfléchir sur les prompts et les éléments voire arguments amenés par ChatGPT :

Il est ici aisé de demander par exemple d’illustrer le propos de ChatGPT par certains passages du texte, de faire vérifier la date, de demander la génèse du texte, etc. Cette démarche de l’étudiant correcteur est je trouve extrêmement pertinente car il doit toujours manipuler les concepts qu’il apprend, mais en exerçant en plus une approche critique des concepts (et des outils à sa disposition).

En conclusion : ChatGPT et l’impact sur la pensée

Comme tout outil, les IA génératives, comme tous les progrès technologiques, vont avoir un impact sur la pensée, notre manière de voir le monde et notre cerveau.

Il est possible que l’utilisation de ChatGPT puisse avoir des effets sur la liberté de penser. D’un côté, ChatGPT peut faciliter l’accès à de l’information et à des idées en générant des textes rapidement et efficacement. Cela peut aider les utilisateurs à explorer de nouvelles idées et à découvrir de nouvelles perspectives.

D’un autre côté, l’utilisation de ChatGPT peut également entraîner un certain degré de dépendance à l’égard de la génération automatique de textes (il n’y a qu’à voir le niveau d’utilisation actuel où les serveurs sont régulièrement hors service), et peut réduire la capacité des utilisateurs à penser par eux-mêmes et à formuler leurs propres idées. En outre, ChatGPT est entraîné sur un grand corpus de données textuelles, il est donc certain qu’il reproduit les biais et les stéréotypes présents dans ces données, ce qui pourrait limiter les perspectives et les idées proposées par le modèle. En fait c’est plutôt un excellent outil de mise au jour de la pensée dominante (dans le corpus ingéré, dont on ignore tout à ce stade).

Il est donc important d’utiliser ces outils d’IA génératives de manière consciente et critique, en sachant que ces outils peuvent aider à explorer de nouvelles idées, mais ne doivent pas remplacer la pensée indépendante et la réflexion personnelle. Il est donc important d’être conscient des limites de ces outils pour éviter de tomber dans un schéma statistiquement dominant !

A l’heure des intelligences artificielles, cultivons donc l’intelligence humaine (et collective) ! N’hésitez pas à rejoindre le groupe IA génératives & enseignement si ces sujets vous intéressent.