Le 22 janvier 2024, le texte pré-final de l’Acte sur l’Intelligence Artificielle de l’Union Européenne (EU AI Act) a été divulgué sur Internet, marquant une étape cruciale vers la régulation des systèmes d’intelligence artificielle (IA) à travers l’UE. Ce cadre juridique horizontal, le premier du genre au monde, vise à équilibrer les avantages de l’IA avec les risques potentiels pour les droits fondamentaux et la sécurité. L’adoption de cet acte par les 27 États membres de l’UE le 2 février 2024 souligne un engagement commun envers une approche basée sur le risque dans le développement et l’utilisation de l’IA… cet engagement est particulièrement structurant pour tous les acteurs économiques, y compris ceux de l’enseignement.

Définition et portée d’application de l’AI Act

L’EU AI Act définit les systèmes d’IA comme des systèmes basés sur la machine, conçus pour opérer avec divers niveaux d’autonomie et pouvant s’adapter après déploiement. Cette définition, alignée sur celle de l’OCDE, établit le cadre dans lequel les systèmes d’IA seront évalués et régulés au sein de l’UE, excluant les systèmes utilisés à des fins militaires ou strictement pour la recherche et le développement scientifique.

L’AI Act vise à assurer que les systèmes d’IA soient sûrs, transparents et gouvernés par des principes éthiques. Il cherche également à protéger les droits fondamentaux des individus, y compris la vie privée et la non-discrimination.

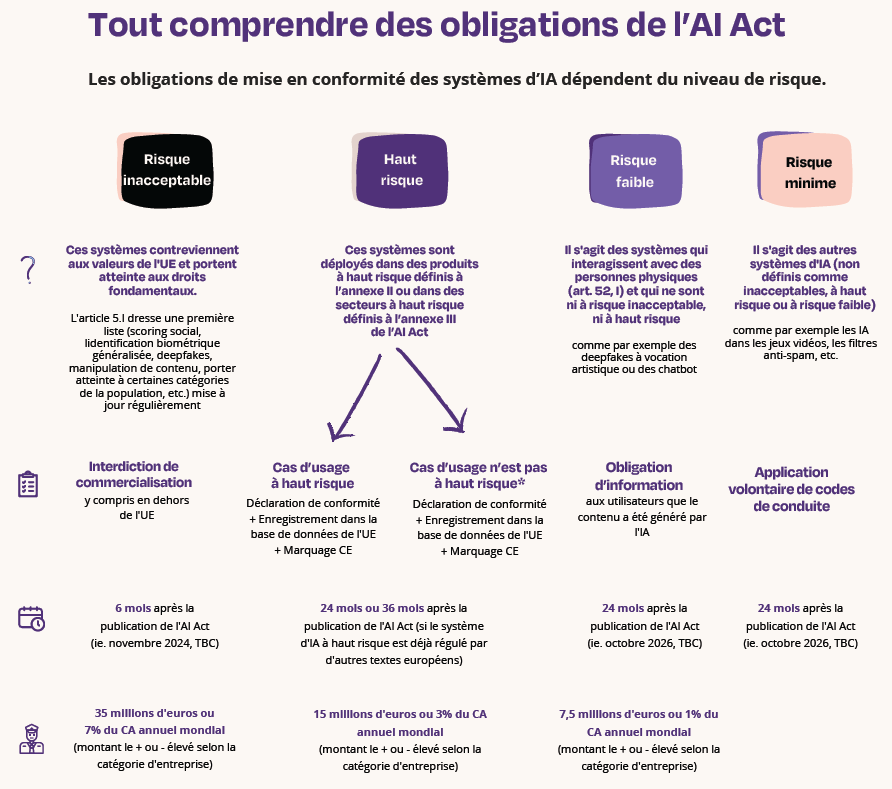

Les systèmes d’IA sont classifiés en différentes catégories selon leur potentiel de risque. Les applications à haut risque, comme celles pouvant influencer l’avenir professionnel des étudiants, seront soumises à des exigences réglementaires strictes, tandis que les systèmes à faible risque bénéficieront d’une approche plus souple.

Les risques des systèmes d’intelligence artificielle selon l’AI Act

Les systèmes d’IA considérés comme présentant un risque inacceptable, tels que l’identification biométrique en temps réel dans des espaces publics, sont strictement interdits. Par ailleurs, une classification précise des systèmes d’IA à haut risque nécessite une conformité approfondie, incluant des obligations rigoureuses en matière de documentation, de supervision humaine et de gouvernance des données.

L’excellent guide de mise en conformité de l’AI Act de France Digitale / Wavestone résume bien les catégories :

Applications dans l’enseignement

Les institutions d’enseignement doivent évaluer comment l’AI Act affecte l’utilisation des systèmes d’IA dans leurs opérations, depuis l’admission des étudiants jusqu’à la personnalisation des parcours d’apprentissage. Notamment les LLMs les IA génératives comportent de nombreux risques à étudier de près.

Cela inclut l’obligation de réaliser des évaluations d’impact, de garantir la supervision humaine et d’offrir des mécanismes de recours en cas de décision automatisée défavorable. Les institutions doivent également sensibiliser et former leur personnel aux principes éthiques et juridiques régissant l’usage de l’IA, tout en explorant les avantages pédagogiques et administratifs de ces technologies dans un cadre réglementé.

Systèmes Prohibés : L’utilisation de systèmes d’IA qui exploitent les vulnérabilités des étudiants ou qui manipulent leur comportement serait interdite. Cela inclut, par exemple, des applications qui pourraient induire des étudiants en erreur concernant leurs capacités ou leurs besoins éducatifs.

Systèmes à Haut Risque : Dans l’enseignement, les systèmes d’IA utilisés pour l’admission des étudiants ou le recrutement du personnel devraient être conformes aux obligations strictes de l’EU AI Act. Cela signifie que les institutions devront s’assurer que ces systèmes sont transparents, équitables et ne discriminent pas, en plus de fournir une documentation détaillée et d’assurer une supervision humaine appropriée. Les systèmes impliqués dans l’évaluation des compétences et des performances des étudiants, nécessiteront probablement une conformité stricte aux normes de transparence, d’exactitude et de sécurité des données.

Je vous propose ici un tableau sur les risques estimés en fonction du type d’usage de l’IA dans l’enseignement… cela n’enlève en rien l’obligation de faire analyser chaque processus / outil IA de votre organisation, mais donne a priori un aperçu de ce que cela pourrait donner :

| Usage de l’IA dans l’enseignement | Niveau de risque |

|---|---|

| 1. Systèmes de recommandation de cours | Minimal |

| 2. Programmes de tutorat personnalisé | Minimal |

| 3. Chatbots pour le support administratif et académique | Minimal |

| 4. Outils de détection de plagiat | Minimal |

| 5. Filtres anti-spam pour les communications électroniques | Minimal |

| 6. Analyse de sentiments dans les feedbacks étudiants | Minimal |

| 7. Plateformes d’apprentissage adaptatif | Minimal |

| 8. Simulations et environnements d’apprentissage virtuels | Minimal |

| 9. Analyse prédictive pour l’orientation professionnelle | Élevé |

| 10. Systèmes d’admission basés sur l’IA | Élevé |

| 11. Outils d’évaluation automatique | Élevé |

| 12. Systèmes de surveillance des examens | Élevé |

| 13. IA pour le recrutement du personnel académique | Élevé |

| 14. Analyse de données pour l’amélioration des programmes d’études | Élevé |

| 15. Génération de contenu pédagogique personnalisé | Élevé |

| 16. Systèmes de reconnaissance faciale pour l’assiduité en classe | Élevé |

| 17. Outils de prévision de la réussite et de l’échec scolaire | Élevé |

| 18. Systèmes de notation automatisés basés sur des critères complexes | Élevé |

| 19. IA pour la création de profils étudiants détaillés | Inacceptable |

| 20. Systèmes de scoring social pour évaluer le comportement des étudiants | Inacceptable |

Modèles d’IA à usage général et mise en conformité selon l’AI Act

Les modèles d’IA à usage général (GPAI) sont également réglementés, nécessitant une documentation technique détaillée et une évaluation des risques systémiques. Les établissements d’enseignement supérieur utilisant ces modèles pour une variété de tâches, telles que la personnalisation de l’apprentissage ou l’analyse des données étudiantes, devront suivre ces obligations pour garantir la sécurité et le respect des droits fondamentaux.

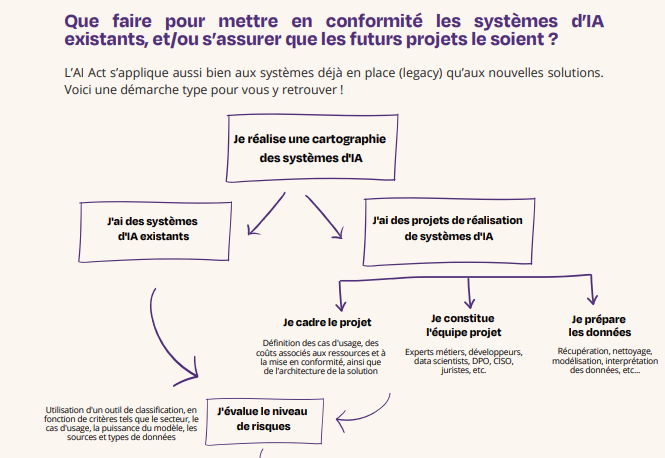

Tout acteur économique (fournisseur, distributeur, déployeur d’IA et personnes morales dans l’UE (y compris entreprises, fondations, associations, labos de recherche, Collèges, Lycées, Universités et Grandes Ecoles, etc.). La mise en conformité avec l’AI Act pour les institutions d’enseignement supérieur implique une démarche structurée pour évaluer et classer les systèmes d’IA en fonction de leur niveau de risque. Cette démarche commence par l’identification de tous les systèmes d’IA utilisés, suivie d’une évaluation rigoureuse pour déterminer si ces systèmes sont considérés comme à haut risque selon les critères de l’AI Act. Pour les systèmes à haut risque, les institutions doivent se conformer à des exigences spécifiques, telles que la transparence, la sécurité des données, et la surveillance humaine. La mise en conformité nécessite également une documentation détaillée et la mise en place de mécanismes de recours pour les décisions automatisées. Les institutions d’enseignement supérieur doivent adopter une approche proactive pour intégrer ces exigences dans leur planification stratégique et opérationnelle.

A noter que la mise en conformité concerne chaque système ou modèle d’IA et non l’entreprise en général. Il faut donc démarrer par une cartographie des système d’IA dans l’organisation !

Transparence de l’usage de l’IA et deep fakes

L’EU AI Act impose des obligations de transparence accrues, en particulier en ce qui concerne les deep fakes. Dans le contexte de l’enseignement supérieur, cela signifie que tout contenu généré par l’IA qui est utilisé à des fins éducatives ou informatives doit être clairement étiqueté comme tel, afin de ne pas tromper les étudiants ou le personnel.

Ainsi, si vous envisagez de développer un module de formation sur la physique quantique, avec pour particularité l’utilisation d’une représentation d’Einstein générée par intelligence artificielle pour animer le cours. Il est essentiel d’indiquer l’usage de cette technologie dans la création de contenu.

Il faut intégrer une note ou un message explicatif dans le module de formation pour signaler que la représentation d’Einstein est le produit d’une intelligence artificielle. Cette mesure vise à clarifier pour les apprenants que l’image a été générée par un algorithme, garantissant ainsi une transparence sans compromettre la qualité ou l’intégrité du contenu pédagogique.

C’est cette règle de clarté et de transparence que nous avons d’ailleurs mis en place à NEOMA pour l’usage de l’IA générative par nos étudiants : ils peuvent l’utiliser, mais doivent l’indiquer explicitement et clairement.

Sanctions et calendrier de déploiement de l’AI Act

Les sanctions pour non-conformité sont significatives, avec des amendes pouvant atteindre 35 millions d’euros ou 7% du chiffre d’affaires annuel mondial. Les établissements d’enseignement supérieur, comme tous les autres acteurs, doivent être conscients de ces sanctions et s’assurer que leurs utilisations de l’IA sont conformes à la loi. Dans le détail :

Une société vendant un système ou modèle d’IA jugé d’un risque inacceptable pourrait se voir infliger des pénalités atteignant jusqu’à 7 % du produit intérieur brut (PIB) mondial ou 35 millions d’euros. Des pénalités peuvent être imposées aux entreprises qui échouent à se conformer aux exigences réglementaires pour les IA considérées comme à haut risque, avec des sanctions pouvant aller jusqu’à 3 % du PIB mondial ou 15 millions d’euros. La fourniture d’informations fausses, partielles ou trompeuses pourrait également donner lieu à des sanctions : 1% du CA mondial ou 7.5 millions d’euros.

L’EU AI Act entrera en vigueur 20 jours après sa publication au Journal officiel de l’UE et sera pleinement applicable après 36 mois, donnant aux établissements d’enseignement supérieur et à d’autres organisations le temps de se préparer et de s’adapter à ces nouvelles exigences réglementaires. La publication devrait intervenir en mai 2024, l’interdiction de commercialisation des IA à risque inacceptable sera à +6 mois (donc a priori novembre 2024), les modèles fondation (LLM) devront être conformes à +12 mois (c’est à dire en mai 2025), les IA à risque faible, minime et haut, à +24 mois (donc mai 2026)… tout doit être fini à +36 mois (incluant les systèmes d’IA à haut risque déjà régulés par d’autres textes européens).

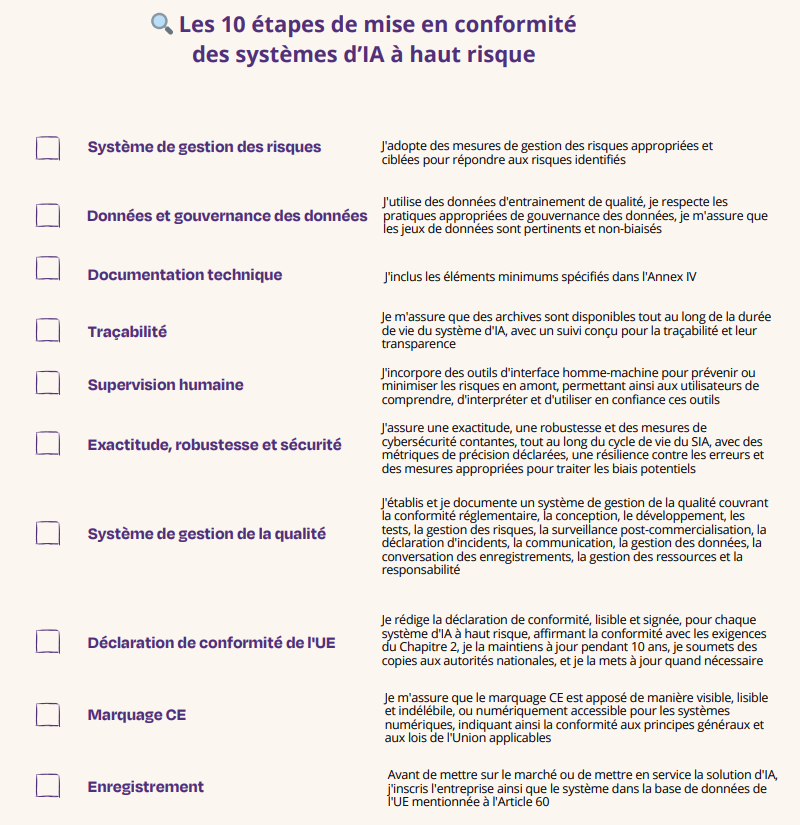

Conclusion : la checklist en 10 points de l’AI Act

L’AI Act représente un jalon important dans la régulation de l’intelligence artificielle en Europe, établissant un cadre clair et normatif pour son utilisation responsable et éthique. Dans l’enseignement supérieur, cet acte incite à une réflexion approfondie sur la manière dont l’IA est employée, en soulignant la nécessité d’une transparence accrue, d’une équité et d’une responsabilité dans l’application de ces technologies puissantes.

Alors que l’UE s’avance vers une ère de régulation de l’IA, les institutions éducatives doivent naviguer dans ce paysage réglementaire avec prudence et engagement envers les principes éthiques qui sous-tendent l’AI Act.

Excellente check list fournie par France Digitale et Wavestone :

3 réflexions sur « L’AI Act en pratique… et dans l’enseignement »