La régulation de l’IA se concrétise en France

L’Europe a franchi un cap décisif avec l’adoption du règlement (UE) 2024/1689 sur l’intelligence artificielle. Premier texte de cette ampleur au monde, il organise les usages de l’IA selon une logique de gestion des risques : certaines pratiques sont interdites, d’autres strictement encadrées, et la grande majorité tolérées sous conditions.

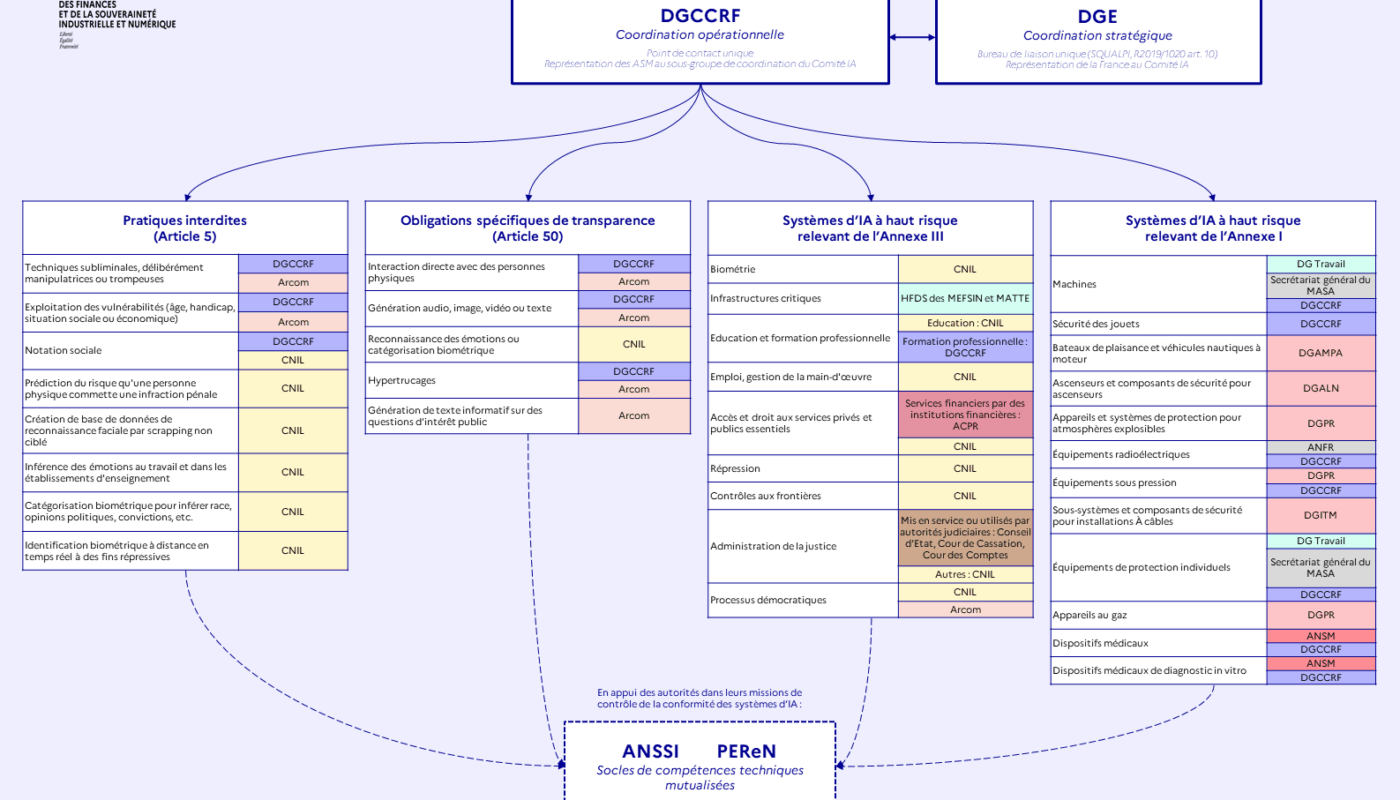

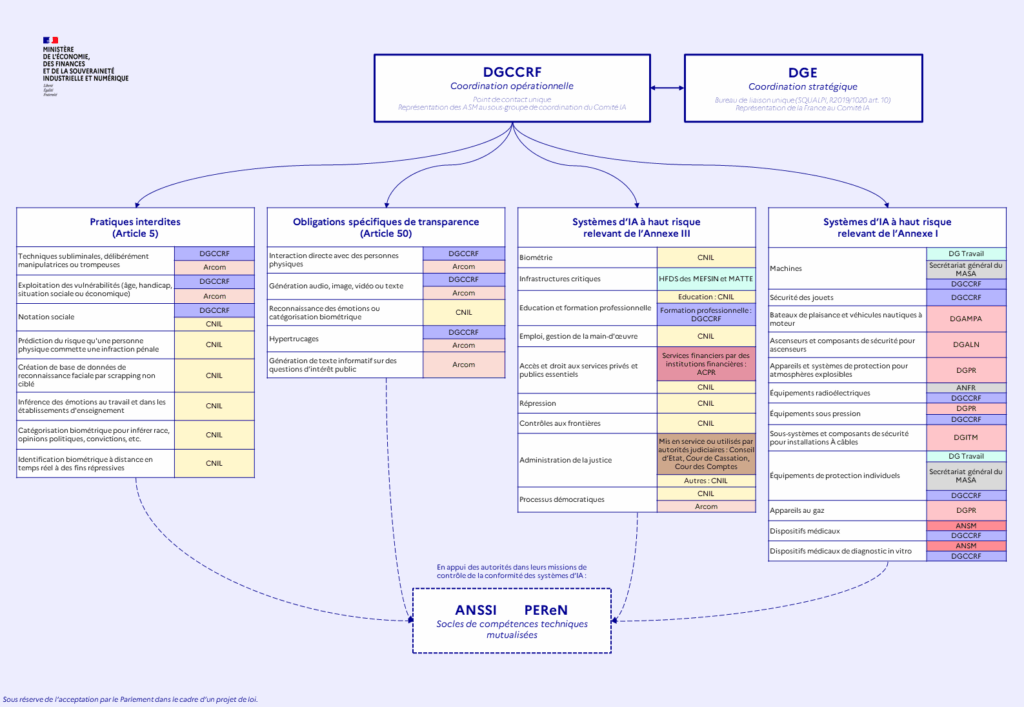

La France, pour appliquer ce règlement, a choisi une voie pragmatique : confier la surveillance non pas à une autorité unique, mais à une constellation d’organismes déjà compétents dans leur domaine. La Direction générale de la concurrence, de la consommation et de la répression des fraudes (DGCCRF) coordonnera l’ensemble, tandis que la Direction générale des entreprises (DGE) assurera le lien stratégique avec Bruxelles.

Un modèle finement pensé (très théorique)… mais qui soulève à mon sens plusieurs questions sur sa robustesse et son efficacité réelle à grande échelle (assez déconnecté du terrain).

1. Trois catégories, trois niveaux de contrôle dans la régulation IA

Les pratiques interdites

Certaines utilisations de l’IA franchissent la ligne rouge et sont bannies sans équivoque. Il s’agit des systèmes conçus pour manipuler ou tromper, exploiter la vulnérabilité des individus (âge, handicap, situation sociale), ou encore mettre en place des systèmes de notation sociale. S’y ajoutent des usages sensibles :

- la police prédictive,

- la reconnaissance faciale par moissonnage massif,

- l’inférence des émotions au travail ou à l’école,

- la catégorisation biométrique (opinions politiques, convictions, orientation sexuelle, etc.),

- l’identification biométrique en temps réel à des fins répressives.

Ces interdictions sont surveillées par trois acteurs : la CNIL, la DGCCRF et l’Arcom. Un triptyque censé protéger citoyens et consommateurs face aux dérives les plus graves.

Les obligations de transparence

La deuxième strate du règlement ne proscrit pas, mais exige la clarté. Toute IA qui interagit directement avec des humains, qui génère du texte, des images, des vidéos ou des sons, doit informer l’utilisateur. Idem pour les systèmes produisant des deepfakes ou catégorisant biométriquement des individus : impossible de masquer la machine derrière l’illusion.

La mission de contrôle est partagée entre la DGCCRF, l’Arcom et la CNIL, chacune spécialisée selon les usages. L’enjeu : éviter que les citoyens ne confondent humain et machine, ou qu’ils ne soient trompés par un contenu artificiel sans en avoir conscience.

Les systèmes d’IA à haut risque

C’est ici que le dispositif prend de l’ampleur. Deux annexes structurent le contrôle :

- Annexe I : produits déjà réglementés (machines industrielles, dispositifs médicaux, équipements de sécurité, appareils de gaz, etc.). L’IA intégrée à ces systèmes se retrouve automatiquement dans la catégorie « haut risque ». Les autorités sectorielles existantes (ANSM, DGPR, DGCCRF, etc.) voient donc leur périmètre élargi.

- Annexe III : usages critiques par nature, tels que la biométrie, l’éducation et la formation professionnelle, l’emploi et la gestion de la main-d’œuvre, la justice, la répression, les infrastructures critiques ou encore les processus démocratiques. Ici, la surveillance repose sur un patchwork d’autorités : la CNIL, l’ACPR, la DGCCRF, l’Arcom, mais aussi des juridictions comme le Conseil d’État ou la Cour de Cassation.

L’idée est simple : chaque secteur garde la main sur « ses » IA. Une logique sectorielle qui a le mérite de l’expertise, mais qui ouvre la porte à une fragmentation du pilotage.

2. Coordination et appui technique pour la régulation de l’IA

Face à cette complexité, deux piliers de coordination sont prévus :

- La DGCCRF joue le rôle de chef d’orchestre opérationnel et de point de contact unique avec la Commission européenne. Une responsabilité lourde, qui suppose des moyens renforcés.

- La DGE assure la coordination stratégique, notamment dans les instances européennes, et veille à l’alignement des orientations françaises avec celles de l’UE.

À ces structures s’ajoutent des appuis techniques :

- le PEReN (Pôle d’expertise de la régulation numérique),

- l’ANSSI (Agence nationale de la sécurité des systèmes d’information).

Leur mission : fournir des socles de compétences partagées en IA et cybersécurité, afin d’aider les autorités sectorielles à analyser et contrôler les systèmes d’IA.

3. Analyse critique : promesses et angles morts dans la régulation de l’IA

La force du modèle français est indéniable : précision sectorielle, expertise distribuée, proximité avec les acteurs concernés. On évite le piège d’une « super-autorité » centralisée mais déconnectée des réalités métiers.

Mais derrière cette élégance théorique se cachent trois écueils à mon sens :

- La fragmentation du pilotage. Multiplier les autorités, c’est multiplier les risques de doublons, de délais et d’incohérences. Un système distribué ne fonctionne que si la coordination est fluide et les responsabilités limpides. Or, le schéma actuel pourrait vite ressembler à une jungle réglementaire.

- L’asymétrie des moyens. La CNIL et la DGCCRF, déjà surchargées par leurs missions traditionnelles, vont devoir absorber un flux inédit de contrôles IA. Sans renforcement budgétaire et humain, la régulation restera en partie théorique, voire inapplicable à grande échelle.

- L’absence d’une culture partagée de l’IA responsable. La régulation ne peut pas se réduire à des sanctions et des interdictions. Elle doit aussi accompagner, acculturer, créer une dynamique collective. Aujourd’hui, le dispositif reste technocratique, descendant. Il manque une dimension éducative et inclusive qui embarquerait entreprises, chercheurs, citoyens et administrations dans une culture vivante de l’IA de confiance.

Conclusion sur la régulation de l’IA en France

En choisissant la spécialisation sectorielle, la France fait le pari de l’expertise plutôt que de la centralisation pour sa régulation de l’IA. Ce choix est cohérent, mais il devra être consolidé par :

- des moyens renforcés pour les autorités déjà fragilisées,

- une coordination agile pour éviter la paralysie,

- et surtout, la création d’une culture collective de l’IA responsable.

Car la question n’est pas seulement « qui contrôle quoi », mais « comment faire vivre l’IA de confiance au quotidien ». Sans cette appropriation partagée, la régulation risque de rester une belle mécanique théorique, mais peu opérante face à la vitesse de l’innovation.