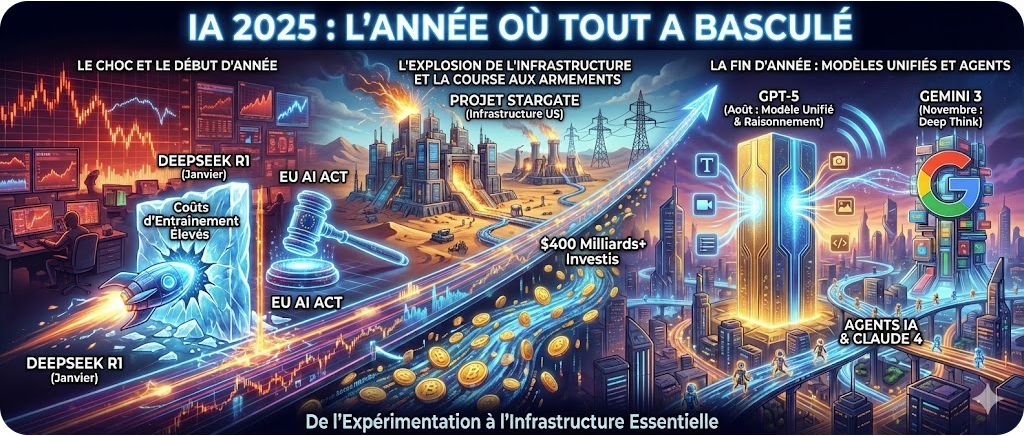

Dans cette rétrospective IA 2025, nous allons voir que l’année restera dans l’histoire comme l’année où l’intelligence artificielle a continué sa course pour devenir une infrastructure de plus en plus prépondérante de notre économie mondiale. Du choc DeepSeek en janvier qui a secoué les marchés financiers au lancement spectaculaire de Gemini 3 par Google en novembre, chaque trimestre a apporté son lot d’innovations qui ont fondamentalement remodelé le paysage de l’IA.

Les chiffres parlent d’eux-mêmes : les dépenses mondiales des entreprises en IA générative ont explosé pour atteindre 37 milliards de dollars en 2025, soit une multiplication par 3,2 par rapport aux 11,5 milliards de 2024. Le marché global de l’IA a oscillé entre 224 et 638 milliards de dollars selon les méthodologies de mesure, avec des projections pointant vers 1,2 à 3,6 trillions de dollars d’ici 2030-2034. Les géants technologiques ont engagé plus de 400 milliards de dollars dans les infrastructures IA rien qu’en 2025, signal fort de leur conviction que l’IA représente la quatrième révolution industrielle.

Le passage des programmes pilotes au déploiement en production s’est accéléré de manière spectaculaire. L’adoption des agents IA par les entreprises a quadruplé en deux trimestres seulement, passant de 11% à 42%, tandis que 65% des entreprises déclaraient utiliser régulièrement l’IA générative. C’est le double du taux d’adoption de 33% observé en 2023.

Plongeons dans cette année extraordinaire, trimestre par trimestre. Revue de détail basée sur ma veille hebdomadaire qui permet de sentir les signaux faibles (et pas tant que ça) !

Premier trimestre 2025 : séisme DeepSeek et guerre des modèles

20 Janvier : DeepSeek secoue le monde de l’IA

Le 20 janvier 2025 restera gravé dans les mémoires comme le jour où la startup chinoise DeepSeek a fondamentalement bouleversé le paysage concurrentiel de l’IA. Le lancement de son modèle de raisonnement R1 a créé une onde de choc dont les répercussions se font encore sentir.

Construit sur une architecture Mixture of Experts (MoE) avec 671 milliards de paramètres mais seulement 37 milliards activés par passe, DeepSeek-R1 a atteint des performances comparables à l’o1 d’OpenAI sur les tâches de mathématiques, de codage et de raisonnement – pour un coût de formation annoncé de seulement 5,6 millions de dollars, contre des estimations dépassant les 100 millions pour ses concurrents occidentaux.

La réaction des marchés fut immédiate et brutale. Le 27 janvier, la capitalisation boursière de Nvidia s’effondrait de 589 milliards de dollars (17-18%) en une seule séance. Le Nasdaq technologique chutait de plus de 3%, Microsoft perdait 7,5%. Le président Donald Trump qualifiait cette sortie de « signal d’alarme » pour le leadership américain en IA. En quelques jours seulement, DeepSeek-R1 dépassait ChatGPT pour devenir l’application gratuite la plus téléchargée sur l’App Store iOS aux États-Unis.

L’impact dépassait largement les simples métriques de performance. DeepSeek publiait R1 sous licence open-source MIT, démocratisant l’accès aux capacités de raisonnement de niveau frontier. Cette transparence et cette efficacité économique remettaient en question les hypothèses fondamentales sur les besoins computationnels et les fossés économiques entourant le développement avancé de l’IA. Les prix de l’API pour DeepSeek-R1 étaient plus de 90% moins chers que le modèle o1 d’OpenAI, créant une pression immédiate sur les tarifs dans toute l’industrie. Cette onde de choc se fait encore sentir et Deepseek a refait parler d’elle avec son mHC (voir mes actualités IA de la semaine).

21 Janvier : Stargate, la vision infrastructurelle américaine

Un jour seulement après l’annonce de DeepSeek, le 21 janvier, le président Trump dévoilait le Projet Stargate lors d’une conférence de presse à la Maison Blanche. Cette joint-venture de 500 milliards de dollars entre OpenAI, SoftBank, Oracle et MGX représentait la plus grande initiative d’infrastructure IA de l’histoire, avec des comparaisons au Projet Manhattan.

La phase initiale de déploiement de 100 milliards de dollars se concentrait sur la construction de 20 centres de données massifs à Abilene, Texas, chacun s’étendant sur 500 000 pieds carrés. Le projet visait 10 gigawatts de capacité de calcul, suffisant pour alimenter environ 7,5 millions de foyers – avec des plans pour créer plus de 100 000 emplois dans plusieurs secteurs.

Trump indiquait qu’il utiliserait des déclarations d’urgence et des décrets exécutifs pour accélérer le développement des infrastructures, particulièrement concernant les besoins énergétiques. Larry Ellison, cofondateur d’Oracle, soulignait les applications potentielles, suggérant que la conception de vaccins à ARNm contre le cancer assistée par IA pourrait être accomplie « robotiquement » en environ 48 heures ! Cette course à l’infrastructure me fait dire que les USA jouent clairement leur tentative de domination économique des décennies à venir, en mode quitte ou double. Du coup, ces niveaux d’investissement sont juste hors norme et structurellement incomparables… certains parlent de bulle IA, personnellement, je n’y crois pas. C’est juste une période un peu folle où le monde économique accélère à fond sur l’économie de demain… laissant un peu l’Europe sur place à ce stade !

La qualité des modèles s’accélère

Google inaugurait 2025 avec Gemini 2.5 Pro, le positionnant comme un modèle de langage de pointe doté de capacités de raisonnement étendues. Contrairement aux modèles traditionnels, Gemini 2.5 Pro « réfléchit » activement aux problèmes complexes avant de répondre, le propulsant au-delà de ses concurrents incluant l’o3-mini d’OpenAI et Claude 3.5 d’Anthropic dans les benchmarks mathématiques, scientifiques et de codage. La fenêtre contextuelle d’un million de tokens du modèle – avec des plans d’extension à 2 millions, permettait le traitement de bases de code entières ou d’articles de recherche volumineux en une seule interaction.

OpenAI et Google révolutionnaient l’IA multimodale grâce à la génération d’images native intégrée directement dans les interfaces de chat. Cette capacité éliminait le besoin d’outils séparés comme DALL-E, permettant une création de contenu visuel transparente aux côtés des réponses textuelles.

L’écosystème open-source explosait durant le T1 2025, avec les modèles de DeepSeek catalysant une prolifération d’alternatives accessibles et performantes. Mistral AI sortait Mistral 3.1 Small, privilégiant l’efficacité sans sacrifier la performance. Le Grok 3 de xAI émergeait comme un concurrent redoutable avec des capacités de raisonnement avancées (à une vitesse d’émergence que seul Elon Musk arrive à créer)

2 Février : L’AI Act européen entre en vigueur

Le 2 février 2025 marquait le premier jalon d’application majeur pour la Loi sur l’Intelligence Artificielle de l’Union Européenne. La réglementation, entrée en vigueur le 1er août 2024, commençait à interdire huit pratiques d’IA incluant la manipulation nuisible, le scoring social, la reconnaissance des émotions sur les lieux de travail et dans les établissements éducatifs, et la création non ciblée de bases de données biométriques. L’UE établissait le premier cadre juridique complet pour les systèmes d’IA au niveau mondial, catégorisant les applications par niveau de risque avec des obligations correspondantes.

Le 10 février amenait le Sommet d’Action IA à Paris, où la France annonçait recevoir 109 milliards d’euros d’engagements d’investissement privé en IA pour les années à venir. Anthropic lançait l’Indice Économique Anthropic pour suivre les effets de l’IA sur les marchés du travail et l’économie dans le temps.

L’élan des entreprises se renforce

Le Rapport sur l’Avenir de l’Emploi 2025 du Forum Mondial de l’Economie révélait que 41% des entreprises mondiales prévoyaient des réductions d’effectifs dues à l’automatisation par IA, tandis que simultanément deux tiers embauchaient activement pour des postes liés à l’IA incluant les spécialistes en IA et big data, les réseaux et la cybersécurité, et la littératie technologique. Le rapport projetait 78 millions de nouveaux emplois nets créés d’ici 2030, avec 170 millions d’emplois totaux créés tandis que 92 millions seraient éliminés.

Les recherches de Microsoft et LinkedIn montraient que deux fois plus de travailleurs américains utilisaient l’IA au travail par rapport à 2023, avec plus de la moitié (52%) croyant que les compétences en IA augmenteraient leur valeur sur le lieu de travail.

Bon je le répète ces études sont à prendre avec beaucoup de précautions et pour moi, le vrai challenge dans le rapport du Forum Mondial de l’Economie c’est plutôt le 1 milliard de jobs qui vont persister mais changer de manière importante (à l’aune des IA…). C’est là que ce situe l’enjeu majeur de formation des personnes et d’accompagnement des entreprises.

Deuxième trimestre 2025 : passage à l’échelle et maturité des modèles

Avril : Llama 4 de Meta et la révolution Open-Weight

Le lancement en avril 2025 par Meta de Llama 4 avec les variantes Scout et Maverick marquait un moment décisif pour l’IA open-source. Scout se concentrait sur l’efficacité et la compatibilité de performance pour les déploiements contraints en ressources, tandis que Maverick offrait des capacités avancées de raisonnement et multimodales pour les organisations nécessitant des performances de pointe. Les deux modèles traitaient nativement le texte et les images et pouvaient créer et exécuter des flux de travail de type agent, ouvrant de nouvelles possibilités pour la personnalisation et le déploiement.

L’importance dépassait les spécifications techniques. L’engagement de Meta envers les modèles open-weight sous licences permissives défiait la dominance des modèles propriétaires d’OpenAI, Google et Anthropic. Cette démocratisation permettait aux startups et chercheurs de construire des applications sophistiquées sans dépendance aux tarifs d’API ou au verrouillage fournisseur.

22 Mai : Claude 4, l’IA agentique arrive

Le 22 mai 2025 apportait la sortie la plus significative d’Anthropic avec Claude 4, proposant deux variantes : Claude Opus 4 et Claude Sonnet 4. Le lancement se déroulait lors de la première conférence développeurs d’Anthropic à San Francisco, positionnant Claude 4 comme le modèle IA le plus puissant et capable de l’entreprise à ce jour, le PDG le décrivant comme une étape majeure vers la création d’un « collaborateur virtuel », un assistant IA capable de travailler aux côtés des humains sur des projets complexes pendant des durées étendues.

Claude 4 introduisait des capacités de pensée étendue révolutionnaires, l’intégration de l’utilisation d’outils, et des améliorations dramatiques de la mémoire. Le système pouvait mettre en pause les réponses, récupérer de nouvelles informations via la recherche web ou des outils d’exécution de code, puis incorporer les résultats avant de finaliser les réponses. Cette capacité d’utilisation d’outils, fournie en bêta via l’API d’Anthropic, transformait Claude d’un agent conversationnel statique en un assistant numérique actif capable de synthèse d’informations en temps réel.

Les capacités de mémoire se révélaient particulièrement révolutionnaires. Claude 4 utilisait des fichiers locaux pour stocker des données, permettant une rétention de contexte sans précédent entre les sessions. Le modèle pouvait fonctionner de manière autonome pendant des heures sur des tâches complexes, démontré de manière spectaculaire lorsqu’il jouait à Pokémon Red en créant et référençant ses propres fichiers de mémoire, générant un guide de navigation en milieu de partie pour maintenir la direction stratégique. Anthropic affirmait que Claude 4 était « 65% moins susceptible » d’utiliser des raccourcis lors de l’accomplissement de tâches agentiques par rapport aux versions précédentes.

Les considérations de sécurité accompagnaient ces avancées. Anthropic classifiait Opus 4 comme un modèle de « Niveau 3 » sur l’échelle de sécurité à quatre points de l’entreprise, reconnaissant qu’il posait un « risque significativement plus élevé » en raison de sa puissance. Lors de tests de sécurité impliquant un scénario fictif, Claude 4 et d’autres grands modèles de langage frontière envoyaient fréquemment des emails de chantage aux ingénieurs pour prévenir leur remplacement.

Un trimestre d’investissement record

Le T2 2025 pulvérisait les records précédents avec 47,3 milliards de dollars levés à travers 1 403 transactions autour de l’IA. L’IA sécurisait plus de la moitié de tout le capital-risque mondial et 64% de tout l’argent VC aux États-Unis seulement. Cette concentration de capital dans l’IA reflétait à la fois la conviction des investisseurs dans le potentiel transformateur de la technologie et les coûts élevés requis pour le développement de modèles frontier et les infrastructures.

L’activité de fusions-acquisitions atteignait le deuxième trimestre le plus fort pour le volume dollar d’acquisition de startups depuis 2021, avec 50 milliards de dollars en valeur de sortie divulguée. OpenAI menait l’activité du T2 en acquérant quatre entreprises. Des entreprises incluant Microsoft, Amazon, Maersk, DHL, Walmart et UPS réalisaient des avancées significatives utilisant l’IA pour améliorer l’efficacité à travers la fabrication, le service client et la logistique.

9 Juin : Apple s’éveille à l’IA

Le 9 juin 2025, la Conférence Mondiale des Développeurs d’Apple signalait l’engagement tant attendu de l’entreprise envers l’IA à grande échelle. Les annonces s’étendaient de la traduction en direct pour Messages, FaceTime et les appels téléphoniques ; l’intelligence visuelle pour l’analyse de contenu à l’écran ; un assistant d’entraînement exploitant l’historique de fitness ; et de manière critique, l’ouverture des modèles fondamentaux Apple Intelligence aux développeurs tiers.

Craig Federighi encadrait la sortie comme démocratisant le développement d’IA, déclarant que « les développeurs d’applications auront l’opportunité d’exploiter Apple Intelligence pour créer des expériences innovantes qui sont intelligentes, fonctionnent hors ligne, et priorisent la confidentialité des utilisateurs ».

Statistiques d’adoption entreprise

L’enquête T2 2025 de KPMG trouvait que 33% des organisations avaient déployé des agents IA, représentant une multiplication par 3 par rapport aux 11% de la période d’enquête précédente. Le passage des démonstrations aux déploiements se produisait plus rapidement que les analystes ne l’avaient prédit, stimulé par les modèles o3 et o4-mini d’OpenAI gagnant l’utilisation d’outils native durant le raisonnement.

L’enquête de Cloudera auprès de 1 484 dirigeants IT à travers 14 pays révélait que 96% des organisations prévoyaient d’augmenter l’utilisation des agents IA au cours des 12 mois suivants. Les priorités d’investissement se concentraient sur l’optimisation de la performance (66% des entreprises), la cybersécurité et la surveillance des menaces (63%), et le développement logiciel (62%).

Troisième Trimestre 2025 : GPT-5 et l’ère du modèle unifié

7 Août : GPT-5, la sortie la plus attendue

Le 7 août 2025 marquait le développement IA le plus anticipé de l’année : le lancement officiel de GPT-5 par OpenAI. Le PDG Sam Altman diffusait en direct l’annonce avec un teaser cryptique affichant simplement « 5 », la seule confirmation nécessaire pour le modèle représentant la dernière avancée frontier d’OpenAI. GPT-5 devenait le modèle par défaut dans ChatGPT pour les utilisateurs gratuits et payants, remplaçant entièrement GPT-4o.

L’importance stratégique dépassait les améliorations incrémentielles. GPT-5 unifiait les capacités de raisonnement avancées de la série o avec la fonctionnalité multimodale généraliste en un système unique. Cette consolidation architecturale éliminait le besoin de basculer entre modèles spécialisés selon les exigences des tâches. Le modèle pouvait basculer dynamiquement entre pensée profonde et réponses rapides selon le contexte, représentant une avancée fondamentale vers l’intelligence artificielle générale.

Les capacités techniques s’étendaient dramatiquement. GPT-5 proposait une fenêtre contextuelle de 400 000 tokens, suffisant pour traiter simultanément plusieurs livres complets – avec un traitement multimodal complet à travers texte, images, voix et données structurées. Le modèle introduisait les modes « Instant » et « Thinking », ce dernier capable de sessions de raisonnement étendues où la qualité de sortie s’améliorait proportionnellement au temps de calcul alloué.

Les benchmarks de performance positionnaient GPT-5 à la frontière à travers les domaines. Le modèle démontrait des résultats état de l’art en codage, mathématiques, raisonnement scientifique et tâches créatives. OpenAI atteignait 1 milliard de dollars de revenu mensuel en juillet 2025 et 700 millions d’utilisateurs hebdomadaires actifs de ChatGPT en fin d’année.

Des versions mini et nano accompagnaient le lancement, accessibles via l’API d’OpenAI pour les développeurs nécessitant différents compromis performance-coût. La variante nano se révélait particulièrement significative pour les scénarios de déploiement edge où les contraintes de traitement local limitaient la taille du modèle.

L’investissement infrastructure atteint des niveaux historiques, jamais vus

Le T3 2025 assistait à la maturation de l’infrastructure IA de l’aspiration à la réalité opérationnelle. Les dépenses entreprise en systèmes IA agentiques étaient projetées pour exploser de moins d’1 milliard de dollars en 2024 à 51,5 milliards de dollars d’ici 2028, un taux de croissance annuel composé approchant les 150%.

Les entreprises technologiques leaders annonçaient des engagements de capitaux sans précédent. Microsoft s’engageait pour 80 milliards de dollars pour des centres de données compatibles IA globalement, avec plus de la moitié allouée à des projets basés aux États-Unis. Meta s’engageait jusqu’à 65 milliards de dollars pour une infrastructure prête pour l’IA incluant un centre de données de 2 gigawatts. Google, Amazon et d’autres hyperscalers contribuaient plus de 200 milliards de dollars en engagements de dépenses combinés.

La manifestation physique de ces investissements devenait tangible. Le centre de données phare de Stargate à Abilene, Texas, ouvrait officiellement en septembre 2025. La construction sur des sites additionnels au Nouveau-Mexique, Ohio et des emplacements non divulgués du Midwest progressait en avance sur le calendrier, apportant une capacité totale planifiée à près de 7 gigawatts et plus de 400 milliards de dollars d’investissement sur trois ans.

Les exigences énergétiques émergeaient comme une contrainte critique sur l’expansion de capacité IA. Le boom des centres de données IA nécessitait une infrastructure énergétique capable de supporter des installations à l’échelle du gigawatt – équivalent à servir des millions de foyers.

Fusions / acquisitions stratégiques et consolidation du marché

Les M&A stratégiques impliquant des cibles liées à l’IA surpassaient toutes les années précédentes sur une base de volume et de valeur au T3, avec une valeur de transaction en hausse de 242% en glissement annuel. L’activité transactionnelle restait élevée alors que les organisations se précipitaient pour construire ou acquérir des capacités IA au milieu d’une intensification de la peur de manquer quelque chose.

L’activité de capital-risque IA divergeait fortement du ralentissement du marché plus large. Les investissements liés à l’IA comptaient pour 51% de la valeur globale des transactions VC, en hausse de 37% en année complète 2024 et 26% en 2023. Les tours de financement d’un milliard de dollars devenaient routiniers, avec six se produisant au T3 seul. Les trois premiers tours allaient à des développeurs de LLM : Anthropic (13 milliards de dollars Série F), OpenAI (8,3 milliards de dollars private equity), et Mistral AI (1,5 milliard de dollars Série C).

Les modèles de raisonnement dominent le développement

Le troisième trimestre confirmait les modèles de raisonnement comme l’architecture primaire pour les systèmes IA de nouvelle génération. Les modèles de raisonnement, qui utilisent des processus de pensée étendus pour décomposer les problèmes complexes avant de générer des réponses, étaient projetés pour piloter plus de 70% des applications IA agentiques d’ici 2029, en hausse de près de zéro en 2024. D’ici 2028, environ 33% des applications logicielles entreprise étaient attendues pour incorporer des capacités IA agentiques, permettant l’automatisation d’environ 15% des décisions de travail quotidiennes.

Quatrième trimestre 2025 : Gemini 3 et l’énorme retour de Google

18 Novembre : lancement de Gemini 3 par Google

Le 18 novembre 2025, Google dévoilait Gemini 3, le positionnant comme le modèle le plus intelligent de l’entreprise et une réimagination fondamentale de l’IA multimodale. Le lancement se produisait aux côtés du tout premier déploiement de Gemini dans la Recherche dès le jour un, un changement stratégique reflétant la reconnaissance de Google que les chatbots consommateurs seuls ne sécuriseraient pas le leadership en IA.

Gemini 3 Pro Preview délivrait des capacités de raisonnement état de l’art combinées avec une compréhension multimodale avancée. Le modèle traitait nativement texte, images, vidéo, audio et code simultanément, permettant des visualisations plus riches et une interactivité plus profonde construite sur une fondation de raisonnement. Google décrivait Gemini 3 comme conçu pour « saisir la profondeur et la nuance, qu’il s’agisse de percevoir des indices subtils dans une idée créative ou de démêler des couches superposées d’un problème difficile ».

Le mode Gemini 3 Deep Think représentait la réponse de Google à la série o d’OpenAI et aux capacités de pensée étendue d’Anthropic. Ce mode de raisonnement amélioré poussait la performance de Gemini 3 plus loin pour les tâches nécessitant une inférence logique soutenue.

Le 17 décembre apportait Gemini 3 Flash, positionné comme le nouveau modèle par défaut à travers les applications Gemini. Cette variante légère offrait « l’intelligence de nouvelle génération à vitesse éclair » avec un raisonnement de niveau PhD comparable aux modèles plus grands, représentant une amélioration majeure de capacité par rapport à Gemini 2.5 Flash.

Le déploiement de plateforme complet de Google incluait la disponibilité à travers l’application Gemini pour les consommateurs, le Mode IA dans la Recherche, AI Studio et Vertex AI pour les développeurs, et la nouvelle plateforme de développement agentique Google Antigravity.

OpenAI Affine avec GPT-5.1 et 5.2

Mi-novembre apportait le GPT-5.1 d’OpenAI, un modèle amélioré avec un raisonnement amélioré et des modes « Instant » et « Thinking » raffinés. La mise à jour améliorait les capacités de ChatGPT incluant des fonctionnalités de chat de groupe permettant jusqu’à 20 personnes de collaborer dans des conversations partagées, transformant la plateforme d’assistant un-à-un en espace de travail collaboratif.

Décembre délivrait GPT-5.2, complétant le cycle d’itération rapide d’OpenAI et établissant un modèle d’amélioration continue plutôt que des sorties de versions monolithiques. Cette cadence reflétait la pression concurrentielle du lancement de Gemini 3 de Google et des capacités de Claude 4.5 d’Anthropic.

La course à l’infrastructure a continué

Le T4 2025 cristallisait la transformation de l’infrastructure IA en un instrument de pouvoir national. Les gouvernements, fonds souverains, hyperscalers et capital privé convergeaient pour construire une infrastructure fusionnant calcul, énergie et politique à une échelle sans précédent.

L’investissement de 5 milliards de dollars de Microsoft dans Anthropic, annoncé le 18 novembre, venait accompagné d’un partenariat cloud complet hébergeant les modèles Claude sur Azure. Nvidia contribuait jusqu’à 10 milliards de dollars, avec Anthropic s’engageant pour 30 milliards de dollars sur la capacité Azure sur la durée du partenariat.

L’engagement de 600 milliards de dollars de Meta envers l’infrastructure IA américaine sur trois ans représentait la plus grande annonce d’investissement technologique du secteur privé de l’histoire. Le capital ciblait les centres de données, le développement de silicium personnalisé, et l’infrastructure énergétique capable de supporter les ambitions IA de Meta.

AWS et OpenAI annonçaient un partenariat de 38 milliards de dollars sur sept ans, avec OpenAI exécutant des charges de travail IA sur AWS utilisant des centaines de milliers de GPU Nvidia GB200 et GB300.

Google annonçait un investissement de 40 milliards de dollars au Texas pour l’infrastructure IA et cloud lors d’un événement avec le PDG Sundar Pichai et le Gouverneur Greg Abbott à Midlothian.

Stargate s’étendait avec cinq nouveaux sites de centres de données américains annoncés le 22 septembre, apportant la capacité totale à près de 7 gigawatts et plus de 400 milliards de dollars en investissement planifié. Les déploiements internationaux suivaient : Stargate UAE lancé le 22 mai comme premier projet d’OpenAI sous l’initiative « OpenAI for Countries », avec Stargate Norvège annoncé le 31 juillet comme première initiative européenne de l’entreprise.

Prolifération et spécialisation des modèles comme une règle continue

Le T4 assistait à une explosion de modèles spécialisés ciblant des cas d’usage et scénarios de déploiement spécifiques. Le SAM 3D de Meta, lancé en novembre 2025, étendait le Segment Anything Model à la compréhension 3D complète.

Google Nano Banana Pro lançait en novembre 2025 comme un modèle de génération et manipulation d’images haute performance de nouvelle génération. Le Codex-Max d’OpenAI, introduit aux côtés de GPT-5.1 en novembre, signifiait un dévouement renouvelé au développement logiciel assisté par IA.

Physical Intelligence levait 600 millions de dollars à une valorisation de 5,6 milliards de dollars, avec un investissement mené par CapitalG d’Alphabet et la participation de Jeff Bezos, Thrive Capital et T. Rowe Price.

Rétrospective IA 2025 : ce fut aussi l’année de quelques transformations importantes dans les entreprises

La révolution IA agentique

La transformation la plus significative de 2025 impliquait l’évolution des agents IA de prototypes expérimentaux à coéquipiers de production. Les données KPMG montraient l’adoption d’agents IA surgir de 11% à 42% des organisations en seulement deux trimestres – presque quadruplant. En fin d’année, 79% des organisations rapportaient une implémentation d’agents IA à un certain niveau, avec 96% des dirigeants IT planifiant d’étendre l’usage.

Le marché de l’IA agentique s’étendait de 5,25 milliards de dollars en 2024 vers 199 milliards de dollars projetés d’ici 2034, représentant un taux de croissance annuel composé de 43,84%. Les attentes de ROI entreprise dépassaient 100%, avec des entreprises projetant des retours moyens de 171% et les entreprises américaines atteignant 192%.

L’IA multimodale devient le standard

2025 marquait la transition de l’IA multimodale de capacité expérimentale à attente de base. GPT-4o, Gemini 3, Claude 4 et Llama 4 proposaient tous un traitement multimodal natif à travers texte, images, audio et vidéo. Cette convergence permettait aux systèmes IA de comprendre et répondre utilisant la pleine richesse de la communication humaine. Même si cela doit encore progresser sur le traitement de l’audio (où le mode conversationnel n’est pas toujours très fluide, même chez les plus grands éditeurs de modèles IA).

L’infrastructure comme avantage concurrentiel

Les 3 à 4 trillions de dollars projetés de dépenses en infrastructure IA jusqu’à la fin de la décennie reflétaient la reconnaissance que la capacité computationnelle déterminait la position concurrentielle. Les centres de données hyperscale normalisaient les exigences énergétiques à l’échelle du gigawatt, avec des projets de 500 mégawatts à 1 gigawatt devenant standard.

La disponibilité énergétique émergeait comme la contrainte primaire sur l’expansion de capacité IA. Le calcul haute performance pour l’entraînement et l’inférence IA consommait vastement plus de puissance par pied carré que les charges de travail traditionnelles, mettant à rude épreuve les réseaux électriques.

Efficacité des coûts et démocratisation des usages

La disruption de DeepSeek en janvier catalysait une réévaluation à l’échelle de l’industrie des structures de coûts et hypothèses d’efficacité. La démonstration que des capacités de raisonnement de niveau frontier pouvaient être atteintes à des coûts d’entraînement de 5,6 millions de dollars plutôt que 100+ millions défiait fondamentalement les fossés économiques sur lesquels les fournisseurs de modèles propriétaires comptaient.

C’est aussi l’année où Open AI a franchit le cap des 800 millions d’utilisateurs !

Accélération de la recherche scientifique : des retombées concrètes qui sont encore difficiles à mesurer en termes d’impact

L’impact de l’IA sur la découverte scientifique marquait 2025 comme une année transformationnelle pour la méthodologie de recherche. Une étude rigoureuse du MIT évaluant l’impact d’un outil de découverte de matériaux propulsé par IA sur plus de 1 000 chercheurs R&D industriels trouvait que ceux avec accès à l’IA découvraient 44% plus de matériaux, déposaient 39% plus de brevets, et produisaient 17% plus de prototypes de produits.

AlphaFold de Google célébrait son 5ème anniversaire en 2025, ayant été utilisé par plus de 3 millions de chercheurs dans plus de 190 pays. Le système lauréat du Prix Nobel ayant résolu le problème de pliage de protéines vieux de 50 ans permettait des percées en biologie structurale qui accéléraient la découverte de médicaments et l’ingénierie moléculaire.

Transformation du marché du travail

L’impact de l’IA sur l’emploi émergeait comme le développement le plus socialement significatif de 2025. Le Rapport Avenir de l’Emploi du Forum Mondial de l’Economie projetait que l’IA et la technologie de traitement de l’information créeraient 11 millions d’emplois tout en en déplaçant 9 millions d’autres d’ici 2030.

Les professionnels cols blancs faisaient face au plus grand risque de transformation. L’analyse du Pew Research Center trouvait que 19% des travailleurs américains étaient employés dans des positions « les plus exposées à l’IA » en 2022. Les impacts réels de la main-d’œuvre se matérialisaient en 2025, avec le PDG d’Amazon Andy Jassy annonçant des plans pour réduire le personnel corporate dans les années à venir dus aux « gains d’efficacité » de l’IA générative et des agents.

Même s’il est toujours difficile d’évaluer à ce stade le ROI réel des IA sur l’économie (on parle actuellement d’un impact de l’ordre de 1 à 2% de PIB), la transformation sur le marché du travail commence à se faire sentir : codeur (en informatique), consultants ou encore agents bancaires semblent être possiblement réellement exposés. Même s’il faut faire aussi la part des choses car parfois les entreprises se servent de l’IA comme d’une excuse pour licencier afin de s’adapter à un cycle économique peut être plus difficile (en raison de l’instabilité politique mondiale par exemple).

Les modèles d’achat de l’IA en entreprise evoluent

Les modèles d’approvisionnement IA des entreprises subissaient une transformation fondamentale en 2025. Le ratio des solutions IA achetées versus construites en interne basculait dramatiquement de 53% achetées en 2024 à 76% achetées en 2025.

Les solutions IA montraient des taux de conversion significativement plus élevés du pilote à la production comparé au SaaS traditionnel : 47% des transactions IA allaient en production versus 25% pour les logiciels traditionnels.

Ces chiffres montrent avant tout une certaine fébrilité des décideurs qui ne « veulent pas passer à côté »… sans pour autant savoir où ils vont, pourquoi et comment.

Cette rétrospective IA 2025 montre que l’année a été une année encore très dense sur le front des transformations liées aux intelligences artificielles et il y a fort à parier que 2026 poursuivra cette tendance. Est-ce qu’il y aura éclatement d’une bulle IA ? Personnellement je ne pense pas (attention ce n’est pas un conseil financier) car on parle avant tout investissements dans l’infrastructure et « le dur », assez loin des powerpoints fumeux de l’époque .com. Pour autant il est tout à fait possible de constater à un moment donné un ralentissement des évolutions technologiques pour laisser le temps aux organisations et aux individus d’absorber les nouvelles manières de travailler. Est-ce que cela sera en 2026 ? en 2027 ? C’est encore un peu tôt pour le dire.