La popularité croissante des détecteurs d’IA dans l’éducation, malgré les avertissements des sociétés de logiciels concernant la précision, est un phénomène à multiples facettes… et inquiétant.

Les détecteurs IA ont malgré tout bonne presse

Pour moi, le principal moteur est le souhait de continuer à « faire comme si de rien n’était » et de limiter/éviter une autre transformation de l’expérience d’apprentissage (qui arrive tellement vite après la période de Covid-19). S’il est possible de prouver l’utilisation de l’IA générative par les élèves ou les étudiants, il sera alors possible d’en interdire purement et simplement l’utilisation. C’est pour moi l’une des plus grandes erreurs qu’un établissement d’enseignement puisse commettre, car cette technologie façonne déjà le travail de millions de personnes et notre lien à l’information !

En outre, les progrès constants de l’IA et des technologies d’apprentissage automatique renforcent la perception d’une amélioration possible de la précision et de la fiabilité de ces systèmes, malgré les limites existantes. Personnellement je ne crois pas vraiment à l’avènement un jour d’un détecteur absolument fiable pour fournir une preuve (et non juste une présomption) d’utilisation d’IA.

Cette vision positive au sujet des détecteurs d’IA est encore favorisée par une ambiance de concurrence entre les institutions pour rester à la pointe de la technologie, en présentant une façade modernisée et innovante. L’accent mis sur la prise de décision fondée sur les données alimente encore cette tendance, en fournissant des mesures quantifiables qui sont très appréciées dans les politiques et les évaluations de l’éducation. Cette tendance est d’autant plus forte que le plagiat et d’autres formes de malhonnêteté académique sont des préoccupations majeures dans le domaine de l’éducation (voir mon article sur : Vers la fin des devoirs à la rentrée à cause de l’IA). Les détecteurs d’IA pourraient constituer un moyen de lutter contre ce problème, bien qu’avec des niveaux de réussite variables… comme le rêve d’une notation automatique de l’authenticité d’une œuvre.

Pourtant les détecteurs IA pénalisent certains profils

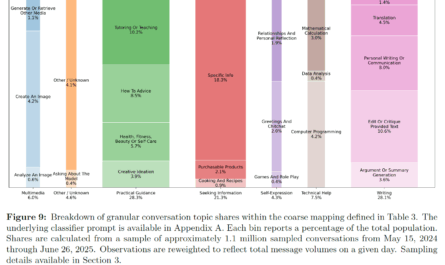

Les algorithmes des détecteurs d’IA évaluent la « perplexité » d’un texte, qui mesure le degré de surprise des mots choisis. Les mots anglais courants font baisser le score de perplexité, ce qui fait qu’un texte est susceptible d’être signalé comme étant généré par une IA. À l’inverse, les mots complexes ou plus fantaisistes donnent lieu à un score de perplexité plus élevé, ce qui permet de classer un texte comme étant écrit par un humain.

Un biais contre les non natifs anglais

Les personnes dont l’anglais n’est pas la langue maternelle, qui utilisent souvent des mots simples, peuvent voir leur travail signalé à tort comme étant créé par l’IA en raison de ce mécanisme.

La structure particulière de leurs phrases, les irrégularités grammaticales ou syntaxiques potentielles et la phraséologie peu courante peuvent s’écarter des modèles typiques des locuteurs natifs, ce qui pourrait déclencher des systèmes de détection de l’IA. En outre, une forte dépendance à l’égard des outils linguistiques numériques pour les corrections pourrait entraîner une normalisation excessive du texte qui reflète la rigidité du contenu généré par l’IA. L’utilisation d’outils de traduction ou de dictionnaires peut conduire à des choix de vocabulaire inhabituels ou trop formels, contribuant ainsi à une fausse détection.

Enfin, le biais inhérent à la formation de l’IA, qui privilégie souvent les textes rédigés par des locuteurs natifs, exacerbe ce problème. Ces constats en anglais existeront dans toute version localisée de ces outils, sans correction forte de ce point, les détecteurs d’IA posent un réel problème d’équité.

Des conséquences possiblement désastreuses sur les étudiants

Les faux positifs des détecteurs d’IA peuvent avoir un impact négatif sur la santé mentale des élèves en provoquant un stress excessif, de l’anxiété et de la démotivation. Ils peuvent se sentir injustement jugés ou se méfier, ce qui peut éroder leur confiance en eux et leur engagement dans le processus éducatif.

L’utilisation accrue de ces détecteurs peut amplifier ces effets, en favorisant un environnement éducatif hostile et méfiant.

Au fil du temps, cela peut s’avérer contre-productif et potentiellement conduire à un déclin du bien-être mental, à une exacerbation du stress et à une diminution des résultats scolaires.

Quelle position adopter face aux IA génératives ?

Naviguer dans l’utilisation croissante de l’IA dans l’éducation tout en évitant les inconvénients des détecteurs d’IA nécessite une stratégie à multiples facettes. Les établissements doivent adapter les outils d’IA à leur contexte éducatif particulier.

A NEOMA, notre approche « test & learn » (qui a été initiée 6 ans avant la publication de ChatGPT par OpenAI), a conduit à une exploration approfondie de cette technologie dans l’éducation à la fin de l’année 2022. Début 2023, un groupe de travail à 360° a été formé pour aligner la vision stratégique de l’école sur les capacités d’IA générative et pour aborder les changements opérationnels. Ce groupe, composé de différentes directions, visait à équilibrer la technologie et l’intelligence humaine, en permettant aux étudiants d’utiliser des outils d’IA pour leurs devoirs, sauf interdiction explicite des professeurs. Cette initiative a également impliqué une évaluation complète du « potentiel de GPT-isation » des évaluations au sein de l’école, garantissant une approche éducative bien équilibrée et une refonte des évaluations lorsque cela s’avère nécessaire.

Enfin, nous avons également formé nos concepteurs pédagogiques et nos enseignants en organisant plusieurs conférences, ateliers et une session de formation obligatoire sur l’aide à l’apprentissage. Les étudiants sont également concernés puisque l’ensemble de notre communauté de 10 000 étudiants a accès à un cours en ligne dédié et badgé sur l’IA générative et l’art de l’ingénierie du prompt.

Le maintien d’une surveillance humaine dans les domaines d’évaluation critiques, la diversification des méthodes d’évaluation, associée à une communication transparente avec les étudiants concernant l’utilisation de l’IA, peuvent favoriser une ambiance éducative de confiance, et c’est ce que nous visons à NEOMA (pour plus de détails voir ici : Novembre 22 – juillet 23, comment NEOMA a mis en place sa stratégie IA générative ?).

Pour moi, il est impératif d’établir des boucles de rétroaction pour l’amélioration continue des outils, d’adhérer aux directives éthiques, de diversifier les méthodes d’évaluation, de promouvoir la culture de l’IA et de défendre des politiques responsables en matière d’utilisation de l’IA par les étudiants. Les professeurs ont aussi vocation d’exemplarité sur ce sujet.

Cette stratégie holistique peut contribuer à exploiter les avantages de l’IA, à minimiser les risques associés aux détecteurs d’IA et à favoriser un environnement éducatif favorable et équitable.

L’enseignement supérieur doit évoluer avec l’IA

Je suggère donc de considérer les résultats positifs potentiels de l’utilisation de l’IA et de l’IA générative dans l’éducation. Ces technologies peuvent améliorer considérablement la qualité de l’enseignement en proposant de nouvelles méthodes d’enseignement, plus adaptées et plus précises, et en rendant le travail universitaire plus précis, plus concret, plus inclusif et plus innovant.

De plus, les gains de performance apportés par l’IA peut redistribuer les ressources éducatives, permettant aux institutions d’allouer des fonds et des ressources humaines à des domaines plus critiques dans le déploiement d’une bonne pédagogie.

Enfin, ces technologies peuvent catalyser l’innovation éducative en encourageant le développement et la mise en œuvre de nouvelles méthodologies d’enseignement et d’évaluation, augmentant ainsi potentiellement la qualité, l’inclusivité et l’efficacité de l’éducation.

Une réflexion sur « Les détecteurs IA ne sont pas bons pour l’éducation »