Installer LM Studio : guide pas à pas

LM Studio est une application conviviale qui permet d’exécuter des modèles de langage (LLM) directement sur votre ordinateur, sans dépendre des services cloud. Elle est compatible Windows, MacOS et Linux et peut se trouver facilement à l’adresse officielle : https://lmstudio.ai/. Elle permet même de faire fonctionner en local des versions de Deepseek-R1… c’est encore qu’un début, mais déjà une belle prouesse !

Prérequis techniques pour installer LM Studio

LM Studio sur macOS

- Processeurs : Apple Silicon (M1/M2/M3/M4), pas de support pour Intel.

- Système : macOS 13.4 minimum (14.0 pour les modèles MLX).

- RAM : 16 Go recommandés (8 Go possibles pour des modèles légers).

LM Studio sur Windows

- Architecture : Compatible x64 et ARM (Snapdragon X Elite).

- CPU : Nécessite le support AVX2.

- RAM : Minimum 16 Go recommandé.

LM Studio sur Linux

- Format : Distribué sous forme d’AppImage.

- Système : Ubuntu 20.04 ou plus récent (x64 uniquement, pas encore de support pour aarch64).

- CPU : Support AVX2 requis.

Ces prérequis sont importants pour permettre à l’outil de fonctionner avec un minimum de confort et d’efficacité. Attention les modèles sont très gourmands en taille donc prévoir suffisamment de RAM au risque de ne pas pouvoir faire fonctionner des modèles assez puissants et donc, d’être déçus.

Pour ma part, je suis Windows 11, avec un Intel i9 à 3.7Ghz, 32 Go de Ram, et une carte graphique RTX4070 avec 12Go et cela tourne raisonnablement bien. Evidemment pour booster les performances il faudrait passer par exemple à la toute dernière RTX5090 avec 32Go… mais pas dispo avant le 31/01 et à partir de 2349 EUR !!

Installation de LM Studio

- Rendez-vous sur le site officiel de LM Studio : lmstudio.ai pour télécharger la version compatible avec votre système d’exploitation (Windows, macOS ou Linux). Actuellement la version est en 0.3.8. Si vous aviez déjà une version antérieure pensez à repartir de l’installateur du site officiel car le processus de mise à jour d’une version antérieure marche mal.

- Pour Windows et macOS, c’est très facile :

- Lancez le fichier d’installation téléchargé

- Suivez les instructions à l’écran

- Pour Linux :

bash# Installez d'abord libfuse2

sudo apt install libfuse2

# Rendez l'AppImage exécutable

chmod u+x LM_Studio-*.AppImage

# Lancez l'application

./LM_Studio-*.AppImage

Télécharger et configurer votre premier modèle LLM

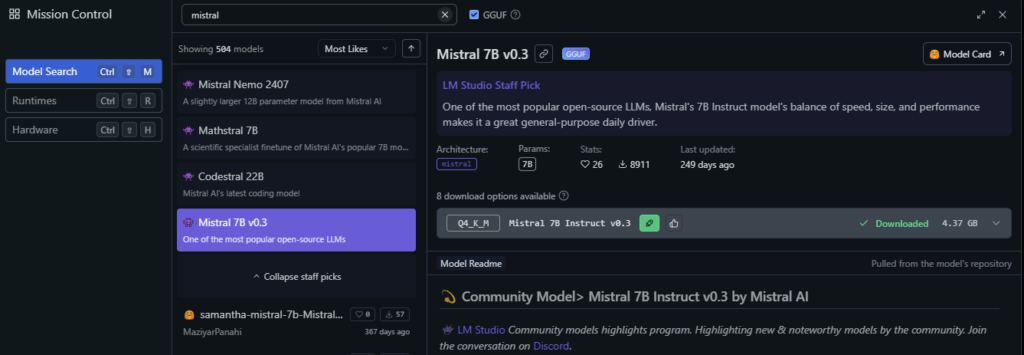

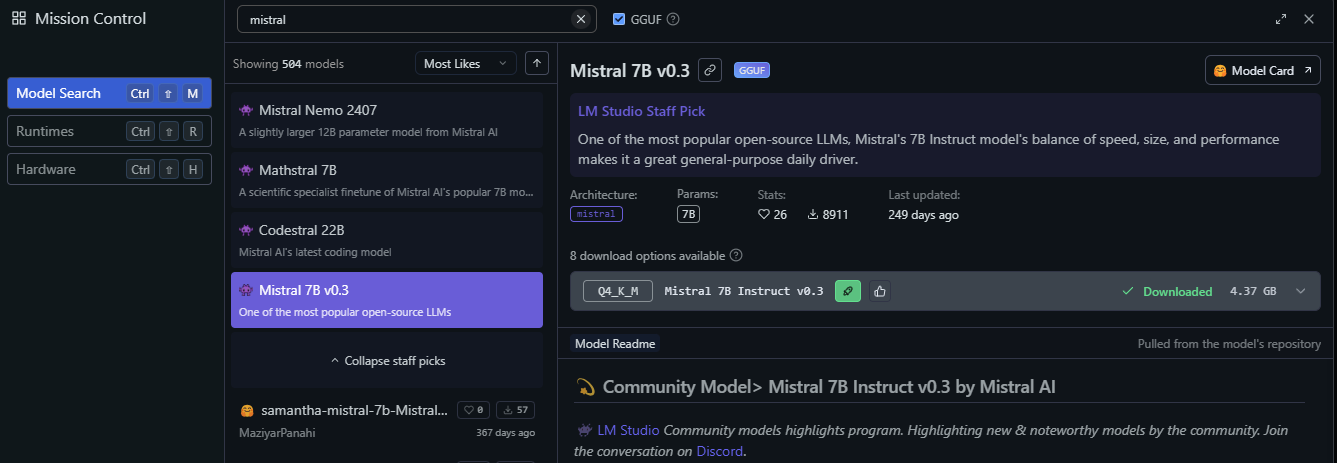

- Une fois LM Studio lancé, accédez à l’onglet Discover (la loupe en haut à gauche) :

2. Dans la barre de recherche, vous pouvez explorer les modèles disponibles. Pour débuter, le modèle Mistral-7B-Instruct est recommandé (en version Q4_K_M) car là vous passerez à peu près sur toutes les configurations (y compris du téléphone portable, voir mon article sur le LLM Mistral-7b sur téléphone portable).

3. Sélectionnez la version compatible avec votre configuration (indiquée en vert). L’outil est bien fait et s’il indique « Likely too large for this machine », oubliez tout de suite et ne téléchargez pas le modèle. Les versions Qn (n allant de 2 à 8) sont des techniques d’optimisation, véritable champs de recherche actuellement. Plus Q est grand, plus le modèle est lourd, donc là encore il faut ajuster puissance de la machine / taille du modèle / optimisation du modèle. Faites des essais pour répondre à vos besoins spécifiques.

4. Cliquez sur Download pour télécharger le modèle. Cela va mettre un peu de temps avant d’être Downloaded.

Utiliser le modèle Deepseek-R1 avec LM Studio

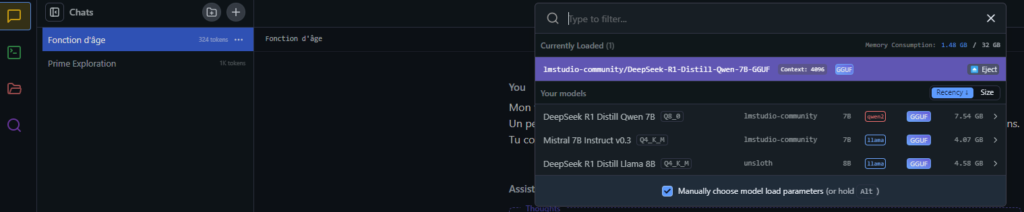

- Une fois le téléchargement terminé, cliquez sur l’icône de tchat dans le panneau de gauche (la bulle en jaune-orangé, voir ci-dessus)

- Dans le menu déroulant en haut de l’interface, sélectionnez le modèle que vous venez de télécharger :

Vous pouvez maintenant commencer à discuter avec le modèle via l’interface de tchat. Evidemment la vitesse d’exécution va dépendre de votre ordinateur, du modèle et de ce que vous demandez. Vous aurez même accès à une version légère de Deepseek-R1, modèle de raisonnement.

Personnellement j’utilise cette version raisonnement : DeepSeek R1 Distill Qwen 7b (que vous retrouvez aussi sur Hugging Face : huggingface.co/lmstudio-community/DeepSeek-R1-Distill-Qwen-7B-GGUF)

Optimisation des performances

- Sur Mac avec puce Apple Silicon, pensez à activer l’accélération Metal pour améliorer les performances

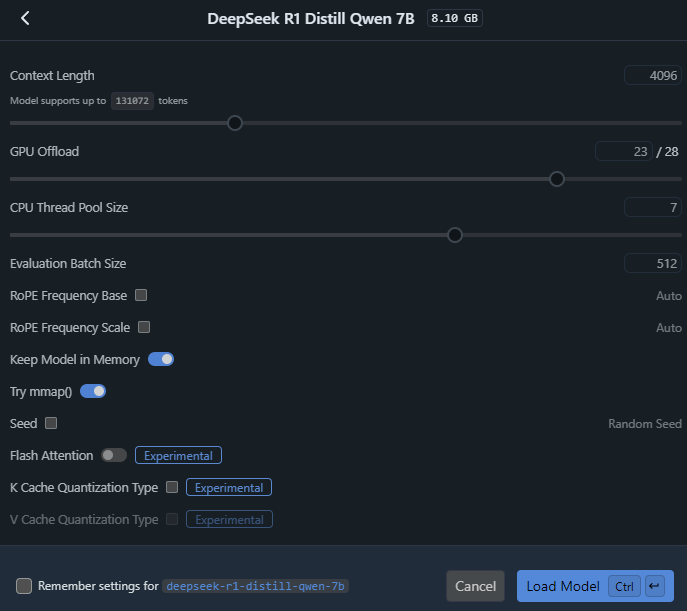

- Ajustez les paramètres du modèle selon les capacités de votre machine, c’est un point assez clé.

- Fermez les applications gourmandes en ressources pendant l’utilisation car cela va venir utiliser votre carte graphique et vos performances de manière très prononcée (le ventilateur va tourner vite).

Du RAG (Retrieval Augmented Generation) en local avec LM Studio

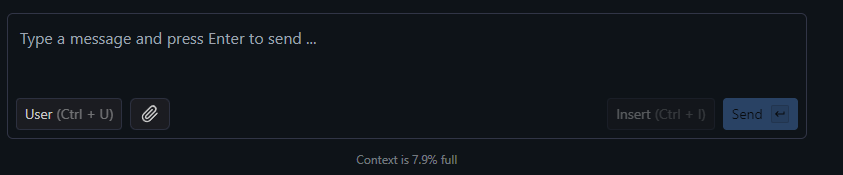

L’outil (et c’est une grande force) vous offre la possibilité de faire du RAG (Retrieval Augmented Generation) en local sur la base de vos documents personnels, sans connexion à Internet. Pour cela, il vous faut soit appuyer sur le trombone, soit glisser-déposer le document dans la fenêtre. Il accepte des .pdf, des .docx et des .txt pour le moment.

Fonctionnalités avancées sur LM Studio

LM Studio offre également :

- Une API locale compatible avec celle d’OpenAI pour les développeurs

- Des options de configuration avancées pour optimiser les performances

- La possibilité de gérer une bibliothèque de modèles

Cette solution vous permet d’avoir votre propre IA conversationnelle en local, garantissant ainsi la confidentialité de vos échanges. Comme vous le voyez, de nombreuses possibilités sont offertes et il vous faut plonger dans les spécificités des différents modèles selon le type de tache que vous souhaitez accomplir.

Pour les utilisateurs de Mac sous processeur Intel, vous pouvez utiliser https://msty.app/ avec DeepSeek en local également.

Sympa, merci pour cet article, j’utilise Ollama ce LLM fonctionne bien. Erol http://www.erolgiraudy.eu